爬虫软件的基本概念

爬虫软件,一般来说,它是一种自动化工具,用于在互联网上抓取、提取信息。简单地讲,通常我们会用它来收集各种网页上的数据。它的功能非常强大,可以帮助我们快速获得大量信息。在我自己的使用经验中,爬虫不仅可以完成数据采集的任务,还是信息分析、竞争对手研究、市场调查等工作的有力助手。

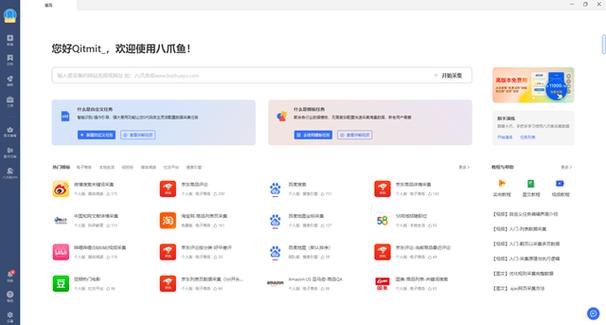

爬虫软件的应用可谓十分广泛,涉及电商、社交媒体、新闻网站、学术数据库等多个领域。例如,在电商领域,爬虫可以用来监控价格变动,收集用户评价。而在社交媒体上,它又可以帮助分析用户行为、挖掘热门话题。这让我意识到,爬虫软件的存在,让我们的工作变得更高效。

爬虫软件的工作原理其实并不复杂。首先,它通过网络请求(通常是HTTP协议)访问目标网站,然后解析返回的HTML文档,从中提取需要的数据。这些数据最终会被存储到数据库中或文件中,方便进一步使用。在这个过程中,爬虫将不断发送请求、接收响应,并解析网页内容,这一系列操作构成了它的核心工作流程。不妨想象一下,就像一个人工搜索员在互联网上收集信息,只不过这个“搜索员”是机器人,效率更高。

爬虫软件常用技术解析

在了解了爬虫软件的基本概念后,我接下来想谈谈其背后使用的技术。这些技术不仅是爬虫正常运行的基础,还直接关系到数据的采集质量和效率。

数据采集技术

在数据采集方面,HTTP协议是首当其冲的技术。爬虫通过这个协议发起请求,获取网页的数据。常用的请求方法,如GET和POST,分别可以用来获取网页内容和提交数据。通过掌握这些基本的请求方式,我能够更灵活地与目标网站进行交互,获取到想要的信息。

解析网页内容则是一项关键技术。工具如XPath和BeautifulSoup非常有用,前者是通过语言描述路径来定位和提取HTML元素,而后者则是一个Python库,能轻松解析HTML和XML文档。这让我在面对错综复杂的网页结构时,能够迅速提取出需要的数据。Scrapy框架也是常见选择,它整合了数据抓取、解析和存储等功能,让爬虫搭建变得更加高效。

处理AJAX请求和动态内容渲染

随着现代网页的动态化,处理AJAX请求成为一项必要技能。许多网站依赖JavaScript来动态加载内容,这使得传统的爬虫难以捕捉到所有信息。我曾经用Selenium这个工具与网站进行交互,通过模拟浏览器行为,获取到动态加载的数据。在使用Selenium时,能让项目的灵活性大大提高,不过这种方式相对比较耗时,因此合理选择工具显得尤为重要。

数据存储与管理

数据存储技术是确保抓取数据能被有效管理的重要环节。我常用的数据库是MySQL和MongoDB。MySQL适合结构化数据存储,而MongoDB则更加适合需要灵活存储的非结构化数据,这让我的数据管理更加得心应手。此外,CSV和JSON文件格式也经常被使用。CSV文件简单易读,适合表格数据;JSON格式则更适用于需要嵌套结构的数据。这些格式的灵活使用让我能够根据需要选择最合适的存储方式。

这个章节涉及的技术让我对爬虫的运作有了深入的了解,无论是数据采集、解析,还是存储管理,各环节都至关重要。在接下来的学习中,我会继续探索更高效的技术应用,以提升我的爬虫性能和数据处理能力。